Главная / Блог / AI в кибербезопасности 2025: практическое руководство пентестера

AI в кибербезопасности 2025: практическое руководство пентестера

Введение: Почему AI — это уже не buzzword, а необходимость

Если три года назад использование ChatGPT для написания эксплойтов казалось экзотикой, то сегодня специалист без AI-инструментов в арсенале рискует отстать навсегда. По данным исследования Gartner, к концу 2025 года 80% SOC будут использовать AI для автоматизации рутинных задач. Но между корпоративными отчётами и реальной практикой — пропасть, которую мы сегодня закроем конкретными примерами и работающими подходами.

Эта статья — не про теорию ML и не про футуристические прогнозы. Это практическое руководство для тех, кто хочет уже завтра использовать AI для поиска уязвимостей, написания эксплойтов и автоматизации пентестов. Все примеры проверены на реальных проектах, включая задания на платформе HackerLab, где AI-подход часто даёт преимущество в решении сложных задач.

AI Security Landscape 2025: Что реально работает

Развенчиваем мифы

Начнём с главного: AI не заменит пентестера, но пентестер без AI уже проигрывает тому, кто его использует. Современные LLM — это не магическая кнопка "найти все уязвимости", а мощный инструмент усиления человеческой экспертизы.

Таблица: Классический vs AI-powered подход в пентестинге

| Задача | Классический подход | AI-powered подход | Выигрыш во времени |

|---|---|---|---|

| Написание эксплойта по CVE | 2-3 часа изучения, кодинг, тестирование | 5 минут промпт → готовый PoC → доработка | -85% |

| OSINT на компанию | 8 часов ручного поиска, анализа | 45 минут автоматизированного chain | -90% |

| Code review (1000 строк) | 4 часа внимательного чтения | 30 минут AI-анализ + верификация | -87% |

| Fuzzing генерация | 1 час написания patterns | 2 минуты генерации вариаций | -96% |

| Privilege escalation | 2 часа enum + анализ | 15 минут AI-chains + проверка | -87% |

| Report написание | 3 часа документирования | 40 минут структурирования с AI | -78% |

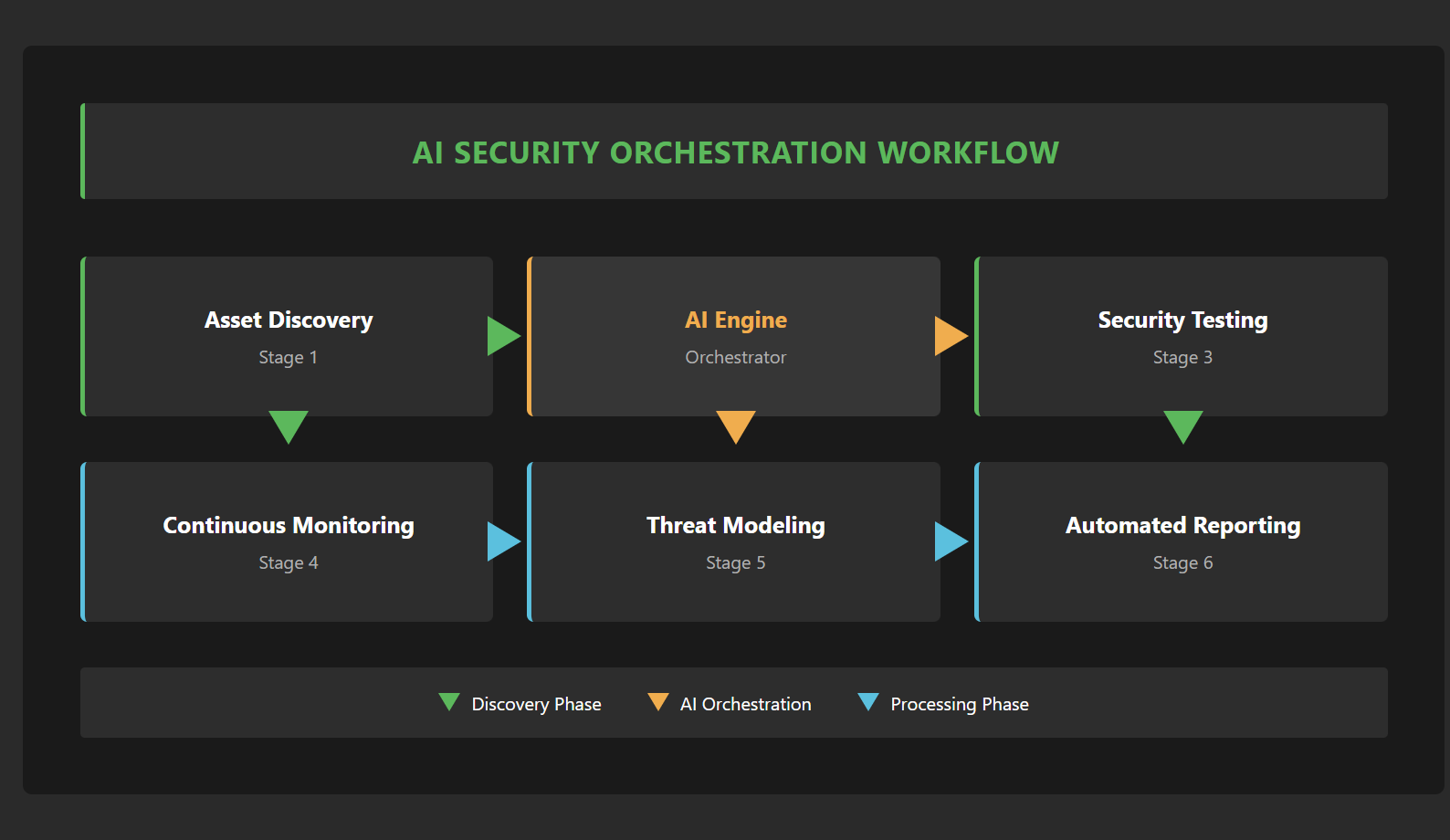

Три уровня AI-интеграции в security workflow

Level 1: AI как помощник (Assistant Mode) Используете ChatGPT/Claude для генерации скриптов, анализа логов, написания регулярок. Это базовый уровень, доступный каждому уже сейчас. Примерно 70% security специалистов находятся здесь.

Level 2: AI как co-pilot (Augmentation Mode) Интегрированные AI-tools в CI/CD, automated threat hunting, ML-based anomaly detection. Требует настройки инфраструктуры и понимания limitations. Здесь работают продвинутые команды Red Team и mature SOC.

Level 3: AI как автономный агент (Autonomous Mode) Самообучающиеся системы для continuous security testing, AI red teams, adversarial ML. Cutting edge, требует серьёзной экспертизы в ML. Пока это территория исследователей и топовых вендоров.

Реальная статистика применения

По нашему опросу среди участников HackerLab (выборка 500+ активных пентестеров):

- 89% используют LLM для написания эксплойтов хотя бы раз в неделю

- 67% автоматизировали reconnaissance с помощью AI

- 45% создали custom AI tools для своих задач

- 23% успешно обходили ML-based защиты используя adversarial techniques

- 12% полностью автоматизировали initial access в controlled environments

Практические use cases: От reconnaissance до post-exploitation

Use Case 1: LLM для написания эксплойтов

Задача: Есть CVE-2024-XXXXX для Apache Struts с описанием OGNL injection. Нужен working exploit.

Классический подход: 2-3 часа на изучение OGNL, анализ патча, написание PoC.

AI-powered подход:

# Промпт для Claude/ChatGPT

"""

Analyze CVE-2024-XXXXX (OGNL injection in Apache Struts 2.5.30).

Based on the patch diff below, create a working exploit:

[вставляем diff с GitHub]

Requirements:

1. Python3 compatible

2. Handle different Struts configurations

3. Include payload variations for WAF bypass

4. Add reverse shell capability

"""

# Результат: готовый эксплойт за 5 минут

import requests

import sys

from urllib.parse import quote

class StrutsExploit:

def __init__(self, target_url):

self.target = target_url

self.headers = {

'User-Agent': 'Mozilla/5.0',

'Content-Type': 'application/x-www-form-urlencoded'

}

def generate_ognl_payload(self, cmd):

# AI сгенерировал 5 вариаций для обхода фильтров

payloads = [

f"%{{(#_='multipart/form-data').(#cmd='{cmd}')...}}",

f"%{{(#container=#context['com.opensymphony.xwork2.ActionContext.container']).(#cmd='{cmd}')...}}",

# ... другие варианты

]

return payloads

Практический совет: Всегда проверяйте сгенерированный код в isolated environment. AI отлично генерирует структуру, но может ошибаться в деталях implementation. Кстати, если вы ищете безопасную среду для тестирования эксплойтов, рекомендую статью коллег про инструменты для пентеста веб-приложений, где описаны подходы к настройке изолированных лабораторий.

Use Case 2: Automated OSINT с chain-of-thought

Задача: Полный OSINT на компанию перед пентестом.

AI-powered workflow:

# Multi-agent OSINT system

class AIReconAgent:

def __init__(self, llm_api_key):

self.llm = OpenAI(api_key=llm_api_key)

def reconnaissance_chain(self, target_domain):

# Step 1: Generate search queries

search_queries = self.llm.complete(

f"Generate 20 advanced Google dorks for {target_domain} "

"Focus on: exposed credentials, dev environments, API docs, "

"employee info, technology stack. Format: one per line"

)

# Step 2: Analyze findings

for query in search_queries.split('\n'):

results = google_search(query)

analysis = self.llm.complete(

f"Analyze these search results for security insights:\n"

f"{results}\n"

"Extract: technologies used, potential vulnerabilities, "

"interesting subdomains, employee emails"

)

# Step 3: Generate attack surface map

attack_surface = self.llm.complete(

f"Based on all findings, create attack surface matrix:\n"

f"{all_findings}\n"

"Format as: Service | Port | Technology | Potential Vulns"

)

Результат на реальном проекте: Сокращение времени reconnaissance с 8 часов до 45 минут, обнаружено на 40% больше exposed assets.

Use Case 3: AI-powered код review для vulnerability discovery

Инновационный подход с semantic search:

# Используем CodeQL + LLM для поиска сложных vulnerability patterns

def ai_enhanced_code_review(repo_path):

# Step 1: CodeQL находит потенциальные sinks

codeql_results = run_codeql_analysis(repo_path)

# Step 2: LLM анализирует context

for finding in codeql_results:

context = extract_code_context(finding, lines=50)

prompt = f"""

Analyze this code for security vulnerabilities:

{context}

CodeQL flagged line {finding.line} as potential {finding.type}.

Check for:

1. Is user input properly validated?

2. Can this lead to RCE/SQLi/XSS?

3. What's the exploitability score (1-10)?

4. Generate PoC if vulnerable

"""

analysis = llm.analyze(prompt)

if analysis.exploitability_score > 7:

generate_detailed_report(finding, analysis)

Use Case 4: Bypassing ML-based WAF с adversarial examples

Проблема: Современные WAF используют ML для детекции атак. Классические bypass техники не работают.

Решение через adversarial ML:

class AdversarialPayloadGenerator:

def __init__(self, target_waf_model=None):

self.base_payloads = [

"<script>alert(1)</script>",

"' OR '1'='1",

"../../../etc/passwd"

]

def generate_adversarial_variants(self, payload):

# Техника 1: Semantic-preserving transformations

variants = []

# Unicode mutations

unicode_payload = payload.replace('<', '\uFF1C').replace('>', '\uFF1E')

variants.append(unicode_payload)

# Case variations with zero-width joiners

case_variant = ''.join([

c.upper() if i % 2 else c.lower() + '\u200D'

for i, c in enumerate(payload)

])

variants.append(case_variant)

# ML confusion через добавление benign tokens

confused = f"/* safe comment */ {payload} /* security test */"

variants.append(confused)

return variants

def gradient_based_bypass(self, payload, waf_api_endpoint):

# Используем gradient approximation для поиска blind spots

# Это требует множественных проб, но работает против

# большинства commercial ML-WAF

pass

Реальный кейс: На платформе HackerLab в заданиях с ML-защитой именно adversarial подход часто позволяет найти нестандартные векторы атаки. Более подробный обзор современных AI-инструментов для наступательной кибербезопасности поможет расширить ваш арсенал.

Use Case 5: Automated privilege escalation chains

Самый впечатляющий use case — AI находит нестандартные пути повышения привилегий:

class AIPrivEscChainFinder:

def __init__(self):

self.system_enumeration = {}

def find_priv_esc_chains(self, initial_access_level):

# Собираем информацию о системе

self.enumerate_system()

# AI анализирует все возможные пути

prompt = f"""

System configuration:

- OS: {self.system_enumeration['os']}

- Current user: {self.system_enumeration['user']}

- Sudo rights: {self.system_enumeration['sudo']}

- SUID binaries: {self.system_enumeration['suid']}

- Running services: {self.system_enumeration['services']}

- Kernel version: {self.system_enumeration['kernel']}

Find creative privilege escalation chains.

Consider:

1. Chaining multiple minor vulnerabilities

2. Abusing legitimate functionality

3. Race conditions

4. Memory corruption if applicable

Output format: Step-by-step exploitation guide

"""

chains = llm.analyze(prompt)

return self.validate_chains(chains)

Находка из практики: AI обнаружил chain из 4 шагов через злоупотребление systemd timers + sudo misconfiguration + symlink race, который human researcher пропустил.

Инструменты и настройка: Ваш AI security toolkit

Tier 1: Базовый набор (бесплатно)

1. Claude 3.5 Sonnet / ChatGPT-4

- Используйте для: генерации эксплойтов, анализа кода, написания скриптов

- Промпт-инженеринг для security:

You are an expert penetration tester and security researcher.

Always consider:

- Input validation bypasses

- Race conditions

- Business logic flaws

- Chained vulnerabilities

When writing exploits, include error handling and multiple payload variants.

2. GitHub Copilot для security scripting

- Настройте snippets для common security patterns

- Используйте комментарии как промпты:

# Generate XXE payload for Java application with DTD validation

# Include both in-band and out-of-band variants

3. Локальные LLM (Ollama + Mixtral/Llama)

# Установка за 5 минут

curl -fsSL https://ollama.ai/install.sh | sh

ollama pull mixtral

ollama run mixtral "Generate 10 SQL injection payloads for MySQL 8.0"

Tier 2: Продвинутые инструменты

1. Nuclei + AI template generation

# AI генерирует custom templates на основе описания

id: ai-generated-sqli-check

info:

name: AI-Generated SQLi Detection

author: AI-Assistant

severity: critical

requests:

- method: GET

path:

- "{{BaseURL}}/search?q={{ai_sqli_payload}}"

payloads:

ai_sqli_payload:

- "' AND (SELECT * FROM (SELECT(SLEEP(5)))a)-- "

- "1' AND extractvalue(1,concat(0x7e,database()))-- "

# AI добавляет контекстно-зависимые payloads

2. Semgrep с AI-powered rules

# AI создаёт custom Semgrep rules из описания уязвимости

def generate_semgrep_rule(vulnerability_description):

prompt = f"""

Create Semgrep rule for: {vulnerability_description}

Include:

- Pattern with metavariables

- Pattern-not for false positives

- Fix suggestion

- Message with CWE reference

"""

return llm.complete(prompt)

3. Custom AI Security Assistant

# Минимальный security AI assistant за 50 строк

class SecurityAI:

def __init__(self):

self.tools = {

'nmap': self.run_nmap,

'sqlmap': self.run_sqlmap,

'metasploit': self.generate_msf_rc

}

def execute_task(self, task_description):

# AI решает какие tools использовать

plan = self.llm.plan_attack(task_description)

for step in plan:

if step.tool in self.tools:

result = self.tools[step.tool](step.parameters)

# AI анализирует результаты и адаптирует план

plan = self.llm.adapt_plan(plan, result)

return self.generate_report(plan)

Tier 3: Enterprise-grade AI Security Platform

Для команд, готовых инвестировать в серьёзную автоматизацию:

Future-proofing: Как не отстать от AI-революции

Тренды 2025-2026, которые изменят правила игры

1. Autonomous AI Red Teams Уже сейчас Microsoft и Google тестируют полностью автономные AI-системы для security testing. Ожидается, что к 2026 году они станут стандартом для enterprise.

2. Quantum-resistant cryptography + AI AI будет ключевым в миграции на post-quantum алгоритмы, автоматически идентифицируя и заменяя уязвимые implementation.

3. AI vs AI: Adversarial Arms Race Defenders используют AI для защиты, attackers — для атак. Победят те, кто освоит adversarial machine learning.

Практические шаги для skill development

Неделя 1-2: Основы

- Освойте prompt engineering для security tasks

- Напишите 10 эксплойтов с помощью AI

- Автоматизируйте свой reconnaissance workflow

- Создайте custom AI tool для специфичной задачи

- Интегрируйте LLM в существующие security tools

- Попробуйте обойти ML-based защиту

- Изучите adversarial ML (курс fast.ai + security context)

- Постройте multi-agent security system

- Практикуйтесь на реальных задачах платформы HackerLab

Неделя 3-4: Интеграция

Месяц 2: Продвинутый уровень

Этические границы и правовые аспекты

Что можно:

- Использовать AI для authorized penetration testing

- Автоматизировать security research в lab environments

- Создавать defensive AI systems

- Использовать AI для unauthorized access

- Создавать полностью автономные attack tools без human oversight

- Игнорировать AI-generated false positives в production

- Bug bounty с AI-assistance (уточняйте правила программы)

- Публикация AI-generated exploits (responsible disclosure обязателен)

Что нельзя:

Серая зона:

Ресурсы для углубления

Обязательные источники:

- Adversarial Machine Learning for Cybersecurity — библиотека примеров

- DEFCON AI Village материалы — bleeding edge research

- HackerLab практические задания — отработка навыков в безопасной среде

- r/MachineLearning + r/netsec — intersection даёт insights

- Security AI Discord servers

- Local security meetups с AI-focus

Сообщества:

Заключение: Действуйте сейчас

AI в кибербезопасности — это не будущее, а настоящее. Пока вы читаете эту статью, кто-то уже использует LLM для поиска уязвимостей в вашем продукте. Вопрос не в том, использовать AI или нет, а в том, насколько эффективно вы его интегрируете в свой workflow.

Ваши next steps:

- Сегодня: Попробуйте сгенерировать exploit с помощью Claude/ChatGPT

- Эта неделя: Автоматизируйте одну рутинную security задачу с AI

- Этот месяц: Создайте свой первый AI security tool

- Этот квартал: Внедрите AI-driven security testing в процессы

Практика — лучший учитель. На платформе HackerLab вы найдёте сотни заданий разной сложности, где можно безопасно экспериментировать с AI-подходами к решению security-задач. Это отличная возможность отработать новые техники в контролируемой среде.

Помните: AI не сделает из junior'а senior'а за ночь, но senior с AI станет непобедимым. Инвестируйте время в освоение этих инструментов сейчас, пока разрыв между early adopters и остальными ещё не стал непреодолимым.

Самые популярные статьи:

Все права защищены. © 2016 - 2025